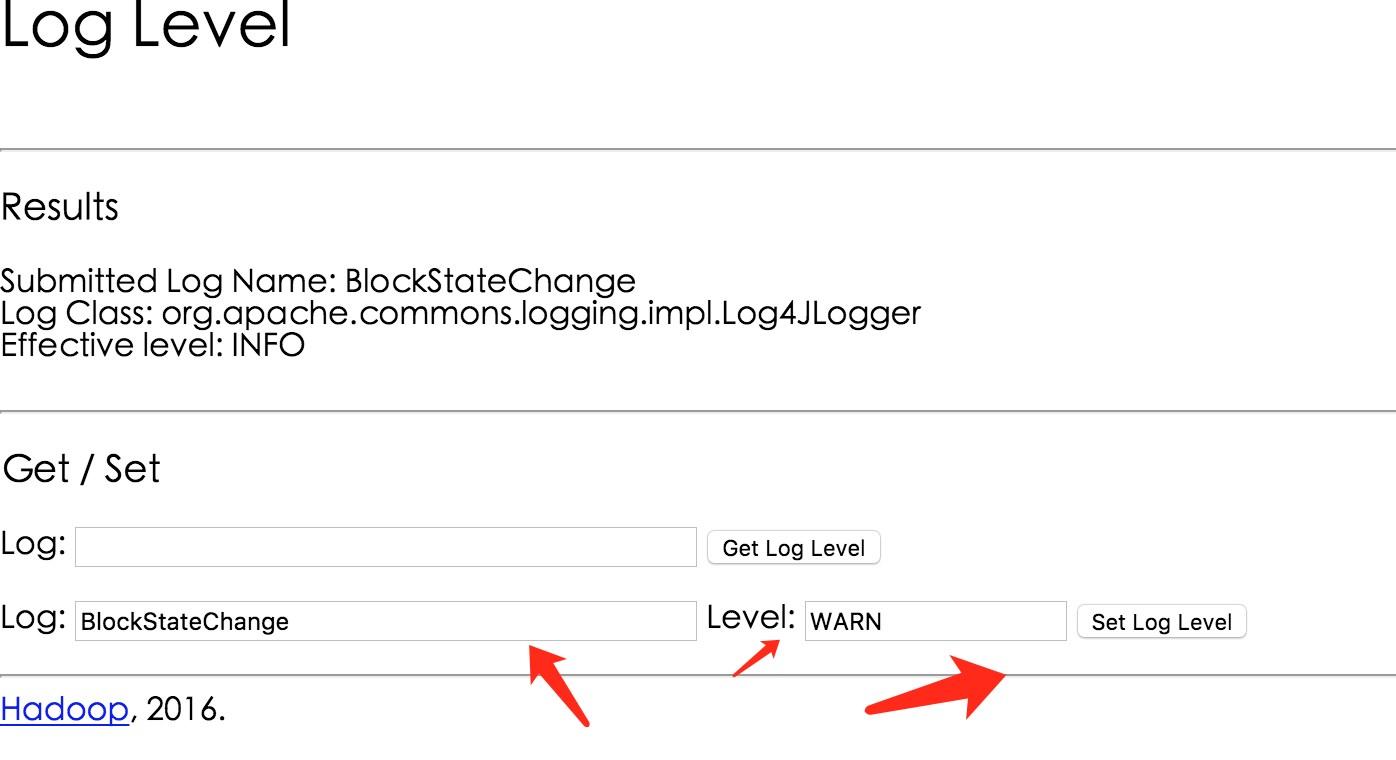

如何修改Hadoop的默认日志级别,还真是麻烦 2016-11-24 16:25:32 鄙人使用的Hadoop版本为2.6.4。Hadoop的默认日志级别为INFO,对于百台以上的集群,如果文件操作频繁的话,NameNode会狂打日志,对性能会有一定的影响。 我们可以通过`http://<namenode:50070>/logLevel`在线修改NameNode的日志级别。如下所示:  但是,如果NameNode重启的话,又得重新设置,好麻烦。 怎么设置默认的日志级别为WARN呢? Hadoop使用的是log4j记录日志,我们理所当然会想到去修改`${HADOOP_HOME}/etc/hadoop/log4j.properties`,但是改完重启,你会发现然并卵!!! 尼玛,这是为啥,认真看了下`log4j.properties`的配置说明,发现一个关键点: ``` # Define some default values that can be overridden by system properties hadoop.root.logger=WARN,console ``` 意思就是说,这里的配置会被系统属性覆盖! 于是乎,查了下可能会设置系统属性的脚本,发现需要修改以下2个文件,才能把默认的日志级别改掉(我这里只改的HDFS的,Yarn的自行参考即可): 第一处是`${HADOOP_HOME}/etc/hadoop/hadoop-env.sh`,把INFO改为WARN即可: ``` # Command specific options appended to HADOOP_OPTS when specified export HADOOP_NAMENODE_OPTS="-Xmx30720m -Dhadoop.security.logger=${HADOOP_SECURITY_LOGGER:-WARN,RFAS} -Dhdfs.audit.logger=${HDFS_AUDIT_LOGGER:-WARN,NullAppender} $HADOOP_NAMENODE_OPTS" ``` 还有一处藏的比较深,是启动脚本`${HADOOP_HOME}/sbin/hadoop-daemon.sh`,也需要这样改一下: ``` export HADOOP_ROOT_LOGGER=${HADOOP_ROOT_LOGGER:-"WARN,RFA"} ``` 最后在重启下NameNode就可以了。 线上配合Zookeeper做了HA,所以可以平滑重启,直接使用以下命令先重启standby的NameNode,在将standby切换为active,在重启另一台NameNode就可以了。 ``` # 先重启standby cd ${HADOOP_HOME}/sbin ./hadoop-daemon.sh stop namenode ./hadoop-daemon.sh start namenode # 切换active节点,这里的nn2将被切换为active节点 hdfs haadmin -failover <nn1> <nn2> # 最后重启nn2就完事了,重启方式同上 ``` 非特殊说明,均为原创,原创文章,未经允许谢绝转载。 原始链接:如何修改Hadoop的默认日志级别,还真是麻烦 赏 Prev git diff a b与git diff b a的区别 Next 解决使用Hive创建表出现JDODataStoreException: An exception was thrown while adding/validati的问题